Stable Diffusion보다 훨씬더 이미지를 잘 생성해주는 Flux.1이 출시되었다. Stable Diffusion에서 나와 창업한 이들이 만들었고, 상업용과 공개용 모델이 공존한다. 아무래도 Stable Diffusion의 라이센스가 강화됨에 따라, Flux.1이 각광받을 것 같고, 기본 모델로도 고해상도에서 꽤 잘 이미지를 생성해준다. 아래는 NVidia RTX 4090 (24GB)에서 실행해보았으며 12GB이하 메모리를 지닌 GPU에서는 별도의 조치가 필요하다.

0. 아래는 간단히 생성해본 1024 * 1024 이미지다. 품질이 좋다!

1. Flux.1을 지원하는 ComfyUI 및 ComfyUI-Manager를 설치한다.

https://github.com/comfyanonymous/ComfyUI 에 접속한 후 화면 하단의 아래 Direct link to download를 통해 압축파일을 다운받는다. 그리고 적절한 폴더에 압축을 푼다. 여기서은 d:\dev\ 폴더에 압축을 풀었다고 가정한다.

곧이어 위 압축을 푼 폴더의 하위 ComfyUI/custom_nodes에서 git으로 아래와 같이 다운로드 받는다.

> cd D:\dev\ComfyUI_windows_portable\ComfyUI\custom_nodes

> git clone https://github.com/ltdrdata/ComfyUI-Manager.git

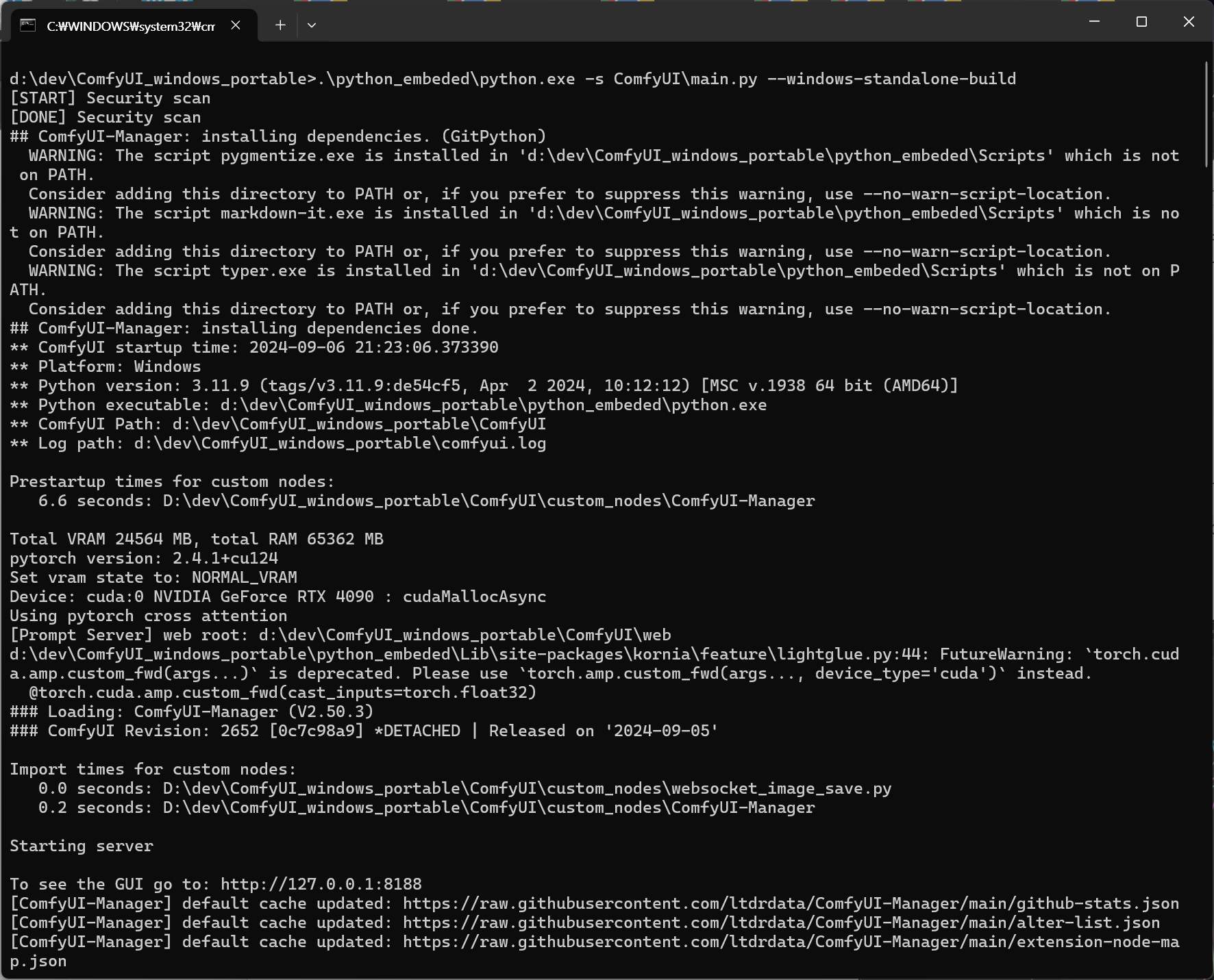

이후 ComFyUI는 아래와 같이 실행하는데, 일단 모델 파일들을 받아보자.

> cd D:\dev\ComfyUI_windows_portable

> run_nvidia_gpu.bat (혹은 GPU가 없다면 run_cpu.bat도 실행가능하다)

2. 아래 모델 파일들을 다운로드 받는다. hugging face에 공개된 모델들이고, hugging face에 가입한 후 필요하면 사용 동의를 해주어야 정상적으로 다운로드 받을 수 있다.

a. https://huggingface.co/Kijai/flux-fp8/tree/main 에서 2개의 파일을 다운로드 받아 아래에 복사해준다. (fp8버전으로 받자)

d:\dev\ComfyUI_windows_portable_nvidia\ComfyUI_windows_portable\ComfyUI\models\unet\

b. https://huggingface.co/black-forest-labs/FLUX.1-dev/tree/main/vae 에서 2개의 파일을 다운로드 받아 아래에 복사해준다.

d:\dev\ComfyUI_windows_portable_nvidia\ComfyUI_windows_portable\ComfyUI\models\vae\

c. https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main 에서 2개의 파일을 다운로드 받아 아래에 복사해준다.

d:\dev\ComfyUI_windows_portable_nvidia\ComfyUI_windows_portable\ComfyUI\models\clip\

d. 아래 사이트 에 접속해서 Download로 json 파일을 하나 받아준다.

https://openart.ai/workflows/maitruclam/comfyui-workflow-for-flux-simple/iuRdGnfzmTbOOzONIiVV

workflow-comfyui-workflow-for-flux-simple-iuRdGnfzmTbOOzONIiVV-maitruclam-openart.ai

(flux 구성을 기초적으로 한 파일이다. ComfyUI를 실행해서 화면에 drag&drop으로 넣어줄 파일이다)

3. ComfyUI를 실행한다.

> cd D:\dev\ComfyUI_windows_portable

> run_nvidia_gpu.bat (혹은 GPU가 없다면 run_cpu.bat도 실행가능하다)

잘 실행되면 아래 비슷한 화면이 나온다. 여기에 아까 받았던 json을 drag & drop으로 화면위에 떨궈준다. 그러면 기본적인 셋팅이 완료된다.

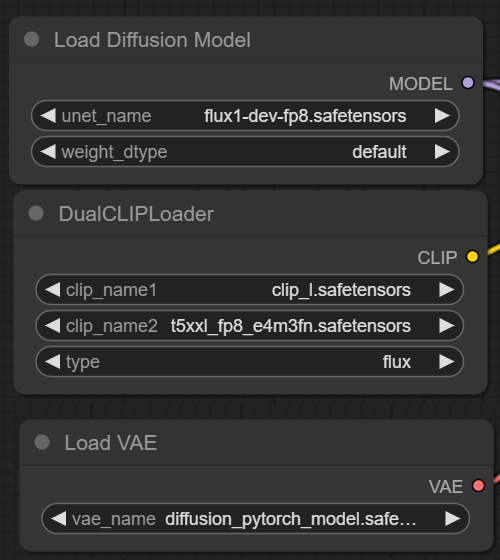

기본 셋팅으로 쓰면 이름이 제대로 설정이 안되서 아래 3가지 셋팅의 명칭은 확인해서 바꿔준다. (Load Diffusion Model, DualCLIPLoader, Load VAE 3가지 박스이다. 다운받은 파일들로 바꿔준다.

이제 Prompt에 적당한 표현을 넣고, Queue Prompt를 눌러보면, 1024*1024로도 멋진 사진이 잘 나오는 것을 알 수 있다. 고해상도에서 기본모델인데도 꽤 잘나온다. RTX 4090으로 약 30초 미만으로 생성되었다. 속도 자체는 기존 Stable Diffusion과 비슷했다.

12GB이하 메모리의 GPU에서는 별도의 방법이 필요하다고 한다. 우선 여기서는 24GB GPU에서 실험한 결과를 공유한다.

'머신러닝AI' 카테고리의 다른 글

| 지적 능력의 대량 생산 시대, 이 시대의 생성형AI가 바꿀 세상, AI비서 (0) | 2025.03.22 |

|---|---|

| 딥러닝이 무엇인가요? (0) | 2024.09.14 |

| AI를 만들고 싶었던 이야기 (1) | 2024.09.05 |

| 인공지능 신경망의 관측을 통한 뇌 이해가 가능할까? (0) | 2024.05.25 |

| 윈도우(windows)에서 실행하는 easy_diffusion & kohya_ss (2) | 2024.05.01 |